🕐 ESTA REPORTAGEM FOI PUBLICADA EM Agosto de 2023. INFORMAÇÕES CONTIDAS NESTE TEXTO PODEM ESTAR DESATUALIZADAS OU TEREM MUDADO.

Empresas e universidades buscam padrão para identificar imagens geradas por IA

Com a popularização de ferramentas de inteligência artificial generativa, como o ChatGPT e o Midjourney, conteúdos gerados por algoritmos passaram a circular lado a lado com os de autoria humana nas redes, em peças publicitárias e até nas salas de aula.

- Desde o início do ano, o Aos Fatos já desmentiu três publicações virais que usavam imagens geradas artificialmente;

- A mais famosa mostra o papa Francisco trajando um casacão branco — que ele nunca usou na vida real;

- Foi possível checar a veracidade da imagem a partir de pequenas distorções na mão e nos óculos do papa — dicas úteis para identificar conteúdos gerados por IA.

O avanço tecnológico tornará cada vez mais difícil identificar a olho nu o que é conteúdo gerado por IAs. Como será possível diferenciar o que foi feito por um robô do que foi feito por humanos? Como saberemos o que é verdade e o que é mentira?

Pensando em solucionar esse problema, pesquisadores, empresas e organizações da sociedade civil estão se movimentando para testar, desenvolver e implementar tecnologias que garantam a autenticidade de conteúdos digitais.

O Aos Fatos falou com três dessas iniciativas:

- A CAI (Iniciativa de Autenticidade de Conteúdo), coalizão de empresas e organizações de mídia e tecnologia ao redor do mundo;

- O Starling Lab, laboratório de integridade de dados liderado pela escola de engenharia da Universidade Stanford e pelo Instituto de História Visual e Educação da USC (Universidade do Sul da Califórnia);

- E o Recod.Ai, laboratório de inteligência artificial e interferência de dados complexos da Unicamp.

Tech vs Tech. As três iniciativas utilizam recentes avanços tecnológicos para combater justamente os problemas causados pela tecnologia. “Ao mesmo tempo que hoje nós temos as tecnologias de IA generativa e suas complicações, nós também temos outras tecnologias que nos ajudam a encontrar soluções”, defende o diretor de operações do Starling Lab, Adam Rose.

O laboratório estuda e testa ferramentas de criptografia e blockchain, para registrar metadados de imagens e documentos digitais. “São tecnologias muito usadas para esconder ou proteger dados, mas que podem também ser utilizadas para verificar informações”, diz.

Rose explica que o blockchain é uma maneira de registrar uma mesma informação em múltiplas cópias descentralizadas. Desse modo, é impossível excluí-la totalmente, uma vez que permanecerá tendo cópias em outros nódulos da rede de armazenamento.

O Starling Lab aplica ferramentas já existentes de blockchain para registrar metadados de arquivos digitais e, assim, protegê-los de manipulações e distorções, além de atestar a autenticidade. Entre as ferramentas usadas nas pesquisas do Starling Lab estão:

- Capture Cam, aplicativo que criptografa e registra em blockchain metadados de fotos tiradas por celular;

- Web Recorder, extensão para browser de internet para registrar de maneira segura endereços e links acessados em uma pesquisa;

- Starling Capture, ferramenta de código aberto em implementação para inserção em câmeras digitais para registro criptografado de imagens.

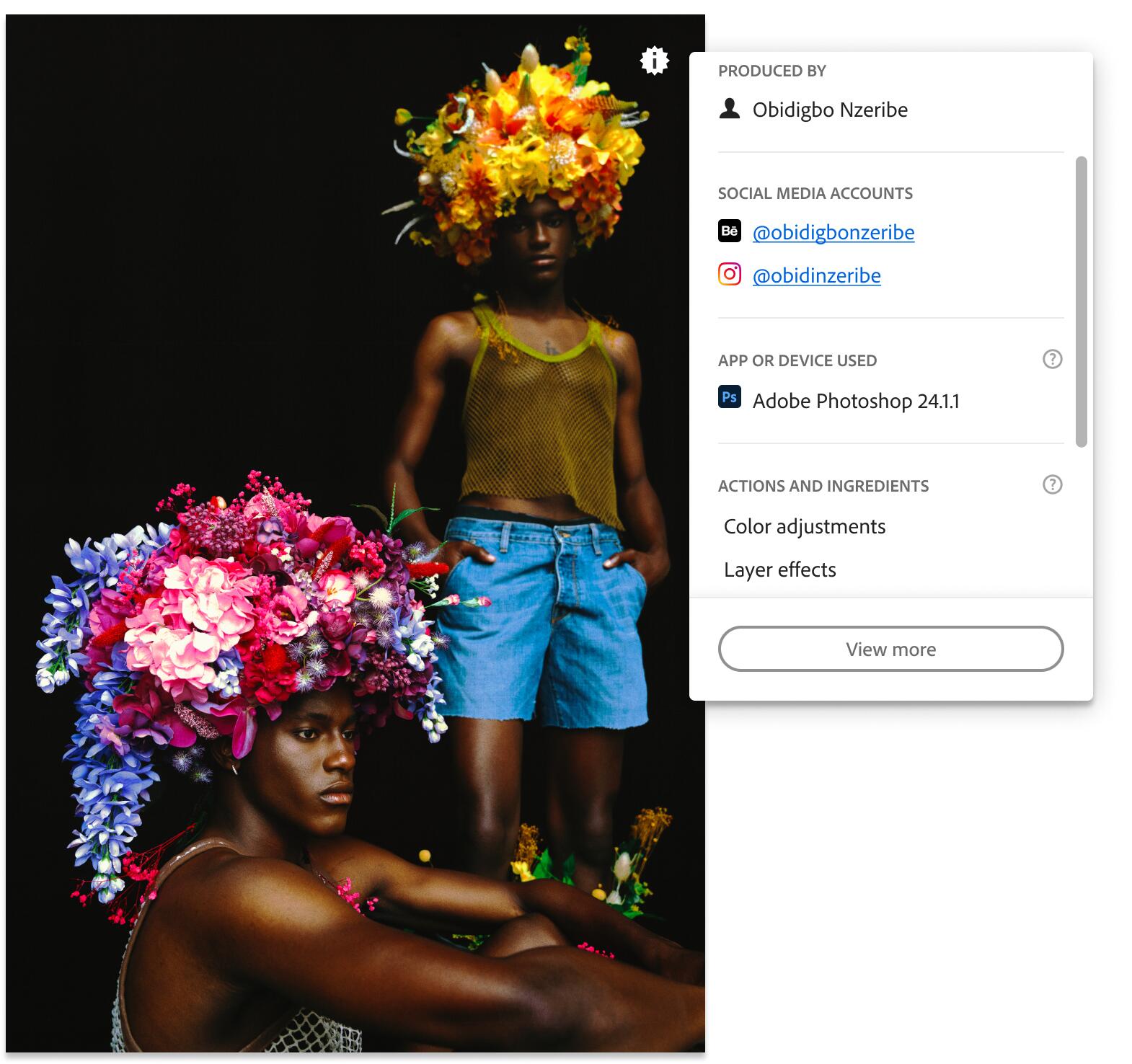

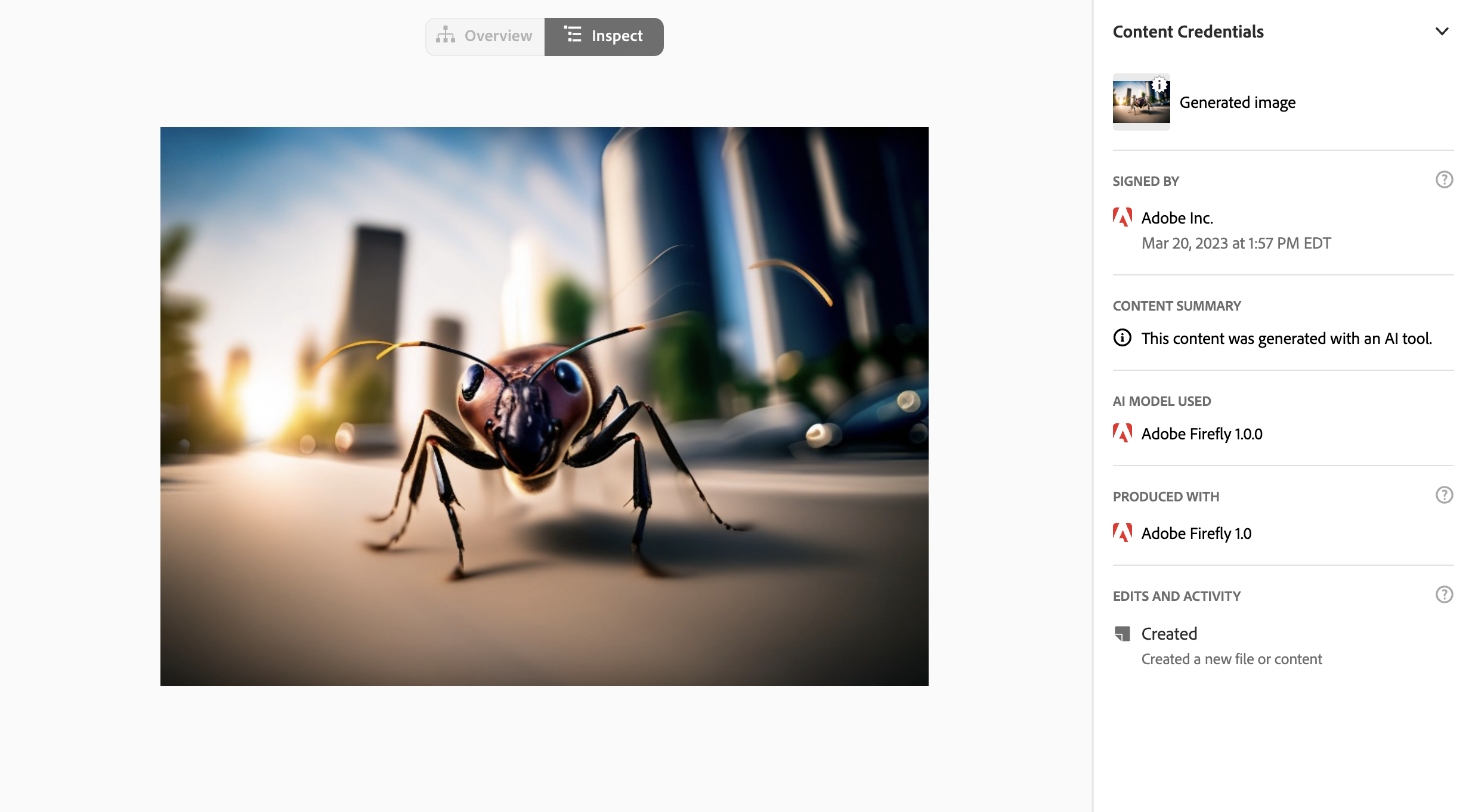

Já a CAI possui suas próprias ferramentas para incluir “credenciais de conteúdo” em imagens, vídeos e documentos digitais. Desenvolvidas em código aberto para poderem ser implementadas em diferentes ferramentas e dispositivos, as credenciais são uma espécie de assinatura digital com informações sobre a criação (data, autor, local, equipamento), edição (histórico, softwares e ferramentas), publicação (data e veículos), e difusão (plataformas).

Credenciais. Informações sobre imagens serão associadas a elas, por meio de criptografia, acessíveis com um clique. (Reprodução/CAI)

Além de serem associadas às mídias via criptografia, esses dados também serão salvos por blockchain e ficarão disponíveis para checagem pela ferramenta Verify. Assim, caso sejam feitas cópias dos arquivos sem credenciais, por meio de prints, por exemplo, é possível fazer a busca reversa dessas informações.

“Essa solução vai permitir que todos possam fazer um fact-checking básico em arquivos digitais”, explica John Reichertz, representante executivo da CAI na América Latina.

Verificação. Na ferramenta Verify será possível consultar as credenciais de conteúdo de imagens que estiverem desacompanhadas dessas informações. (Reprodução/Verify).

Mais de 1.300 empresas e organizações de mídia e tecnologia ao redor do mundo se comprometeram, através da CAI, a implementar as ferramentas em seus produtos e serviços no futuro.

Entre os adeptos da iniciativa estão fabricantes de câmeras, como Canon e Nikon, desenvolvedores de softwares para edição de imagens, como Adobe, sistemas de hospedagem de websites, como WordPress, e empresas de mídia, como a britânica BBC, o jornal americano The New York Times e o grupo alemão Axel Springer, dono do jornal Bild. A IFCN (International Fact-Checking Network), da qual o Aos Fatos faz parte, é uma das integrantes.

Na prática. Apesar do grande número de integrantes, as ferramentas de autenticação da CAI ainda não estão sendo adotadas de maneira ampla. A única plataforma que sinalizou apoio à CAI foi o Twitter — empresa atualmente conhecida como X —, mas ainda não implementou o plugin em seus serviços. Já a Adobe inseriu a ferramenta no Photoshop. Assim, toda imagem editada no software poderá gerar arquivo de credenciais de conteúdo, conforme o protocolo da CAI.

Em contrapartida, o Starling Lab já está adotando ferramentas de blockchain para autenticação de mídias digitais em parceria com veículos jornalísticos e arquivos históricos, entre eles:

- Parceria com a fundação Shoa — instituto de história visual e educação da USC (Universidade do Sul da Califórnia) — para gravar e armazenar via criptografia e blockchain depoimentos de sobreviventes do Holocausto;

- Registro autenticado de fotografias e documentos da transição de poder entre Donald Trump e Joe Biden na presidência dos Estados Unidos entre 2020 e 2021 produzidos em parceria com fotógrafos e jornalistas da Reuters;

- Dossiê criptografado com provas fotográficas de possíveis crimes de guerra cometidos contra escolas durante a guerra da Ucrânia.

“Nosso objetivo a longo prazo é que a maior parte dos conteúdos que circula na internet tenha as informações necessárias para que as pessoas possam saber sua proveniência”, defende Reichertz.

Ele compara o protocolo criado pela iniciativa com rótulos nutricionais presentes em alimentos industrializados para atestar sua validade, qualidade e segurança. “A ideia é que se não houver informações sobre a proveniência, a mídia será automaticamente questionável. Isso se tornará tão prevalente no futuro que a ausência de informações indicará que algo não está certo”, explica.

“Não é uma cura ou uma panaceia, mas é um passo importante para um futuro com informações mais íntegras disponíveis”, pondera o diretor do Starling Lab. Ele reconhece que mesmo com as tecnologias de criptografia e protocolos de assinatura digital como o C2PA, alguns arquivos digitais ainda circularão sem autenticação. “Isso não quer dizer que o conteúdo é falso. Só significa que temos que encontrar outras maneiras de verificá-lo.”

Checagem automatizada. Se o Starling Lab e a CAI trabalham com formas de autenticar conteúdos verdadeiros, o Recod.ai pretende desenvolver técnicas para identificar conteúdos falsos, em uma espécie de automação da checagem de fatos.

“Existem os esforços ativos e os passivos. Colocar uma marcação é uma ação ativa. Já desenvolver um detector, como o nosso trabalho, é uma ação passiva. São abordagens complementares”, explica o professor Anderson Rocha.

Ele foi o coordenador do projeto Déja Vú, que desenvolveu uma inteligência artificial capaz de identificar mídias manipuladas ou editadas. “O objetivo era ajudar a identificar falsificações com o uso de tecnologia como Photoshop, edições pontuais que ainda exigiam o humano para criar o conteúdo”, explica.

O projeto foi desenvolvido entre 2017 e 2022, antes, portanto, da popularização de ferramentas de IA generativa. Frente a essa nova realidade, o laboratório está prestes a iniciar as pesquisas para um novo trabalho, que pretende usar a própria tecnologia para identificar conteúdos gerados artificialmente. “A ideia com esse novo projeto é ser capaz de identificar realidades sintéticas como, por exemplo, deep fakes de imagem de vídeo e de áudio”, diz.

Enquanto o projeto não sai do papel, ele acredita que outros esforços precisam ser feitos para lidar com os possíveis problemas da criação de conteúdos gerados por inteligência artificial.

“A gente precisa de três peças fundamentais para lidar com o que a gente tá vivendo hoje. Você tem que ter um esforço técnico — que é o que nós propomos na nossa pesquisa — existe um componente necessário que é o componente educativo, então você precisa educar tecnologicamente as pessoas; e existe um um componente regulatório. Se você não tiver essas três caminhando juntas você pode ter problemas sérios”, defende.

Referências:

1. Aos Fatos (1, 2, 3, 4, 5)

2. CNN Brasil

3. CAI (1, 2, 3)

4. Starling Lab (1, 2)

5. Recod.ai

6. Numbers Protocol

7. Web Recorder

8. Fundação Shoa

9. USC

10. Unicamp