🕐 ESTA REPORTAGEM FOI PUBLICADA EM Julho de 2023. INFORMAÇÕES CONTIDAS NESTE TEXTO PODEM ESTAR DESATUALIZADAS OU TEREM MUDADO.

Uso do ChatGPT gera conflitos na sala de aula e acusações de plágio sem provas

Após o ChatGPT ter sido liberado para uso público, uma das principais preocupações no início do ano letivo era em relação a como estudantes poderiam utilizá-lo para enganar professores.

Passado o primeiro semestre, agora docentes também acionam a ferramenta de inteligência artificial generativa na tentativa de descobrir se trabalhos acadêmicos foram fruto de plágio — uma utilização incorreta do ChatGPT, que pode levar a casos de falsos positivos, como argumentam alunos que se sentem lesados.

No mês passado, uma usuária relatou no Twitter que o tio dela teria sido injustamente acusado de plágio por um professor que usou o ChatGPT a partir da premissa equivocada. Segundo ela, o tio conseguiu reverter a reprovação ao demonstrar que a inteligência artificial também alertava, de maneira falsa, que um artigo assinado por um dos professores havia sido gerado por IA.

A história viralizou, com quase 6 milhões de visualizações, e fez emergir queixas similares. Estudante de ciência da computação no Rio de Janeiro, N.O. — que preferiu permanecer anônimo — encontrou no post uma oportunidade para desabafar. Um grupo do qual fazia parte recebeu nota zero após o professor alegar que eles haviam usado IA, o que negam ter feito.

“Ele nos acusou do uso do ChatGPT e não mostrou provas, apenas falou”, relata o estudante, que diz ter procurado o professor, o coordenador do curso e a ouvidoria da universidade para tentar que o caso fosse reconsiderado, por enquanto sem sucesso.

“Tem chances de todas as pessoas do grupo reprovarem e, por conta disso, pagarem seis meses [a mais] no final da faculdade”, lamenta o estudante, que é bolsista. Os membros do grupo terão de passar por reavaliação por não terem visto a notificação que zerou o trabalho, perdendo a chance de apresentar uma nova versão do texto.

N.O. relata ainda que conhece colegas de curso que admitiram ter copiado respostas do trabalho do ChatGPT e, mesmo assim, foram aprovados. “Um trabalho que foi feito assim teve nota e o meu, em que [o ChatGPT] não foi usado, ficou zerado. Queria muito descobrir qual o critério usado”, questiona.

A professora de português A.C., que dá aulas em uma escola particular de São Paulo, conta que usou o ChatGPT para verificar a autoria de trabalhos de alguns de seus alunos do 7º ano do ensino fundamental, após desconfiar dos textos apresentados. Em dois casos, a ferramenta disse que tinha sido responsável pelas redações.

“Conversei com dois alunos. Primeiro falei que o texto tinha sido escrito com vocabulário e profundidade que não eram compatíveis com os apresentados por eles até então. Um nunca admitiu, mas o outro falou que havia usado o ChatGPT.”

A educadora diz que, após a confissão, revelou que havia submetido os textos à avaliação da tecnologia, o que deixou os estudantes “muito surpresos”.

Os dois tiveram a chance de reescrever o trabalho. “Aquele que admitiu o plágio, fez. O que negou até o fim, não”, diz a professora. Segundo A.C., o menino que negou o uso da IA já tinha histórico de cópias. “Eu tenho seis aulas por semana com cada turma, eles escrevem muito, então conheço bem o jeitinho de cada um na escrita.”

DESCONHECIMENTO

A professora paulista decidiu usar o ChatGPT para verificar a autoria dos trabalhos suspeitos após ouvir de uma colega de trabalho que a ferramenta tinha essa funcionalidade. O software, entretanto, não é capaz de executar a função, o que pode resultar em avaliações erradas.

“Existe um desconhecimento, de grande parte de professores, sobre o que é o ChatGPT. Não está bem disseminada a engrenagem de funcionamento dele”, avalia Rafael Zanatta, diretor da associação Data Privacy Brasil.

Ele ressalta que a ferramenta de IA generativa é eficiente “na construção de uma linguagem gramaticalmente sólida”, mas é “muito pobre” na produção de conteúdo.

Zanatta destaca que o design do ChatGPT foi feito para dar respostas categóricas, mesmo que não necessariamente verdadeiras, o que fomenta a confusão. Para ele, a situação é mais grave no caso de professores que estão “desamparados, sem estrutura, sem apoio” e inseridos em instituições que não têm cultura sólida na adoção de inovações para a detecção de plágios.

“Essa é uma questão social de fundo. Acho que a gente vai ter muitos casos parecidos, porque há muita precarização.”

Como funciona?

- O ChatGPT gera textos com base em cálculos de probabilidade, que indicam as palavras mais prováveis de serem as respostas adequadas ao comando dado pelo usuário;

- A tecnologia, porém, não é capaz de entender o sentido do que gera;

- Para fazer os cálculos, o ChatGPT foi treinado identificando padrões de construção de textos disponíveis em seu banco de dados, que foi alimentado com milhões de conteúdos publicados na internet até 2021.

“É um erro achar que o ChatGPT armazena textos criados por ele. Uma vez treinado pela empresa que o criou, a OpenAI, e colocado publicamente, nenhuma informação nova é adicionada. Isso só acontecerá quando for novamente treinado e sair uma nova versão”, explica Lucas Lattari, doutor em ciência da computação e professor do Instituto Federal do Sudeste de Minas Gerais.

Por isso, se um aluno utilizar o ChatGPT para redigir um trabalho acadêmico, o conteúdo gerado não vai ser arquivado pela ferramenta, o que impede a tecnologia de denunciar plágios a partir da comparação com o que ela própria criou a partir de comandos de outros usuários.

Há programas específicos que prometem analisar textos para revelar se foram plagiados. Entretanto, ao contrário de programas capazes de detectar se um estudante copiou outros autores, as tecnologias de identificação de textos de IAs são incapazes de apresentar as fontes que embasam a conclusão, impossibilitando revisão humana.

ALARME FALSO

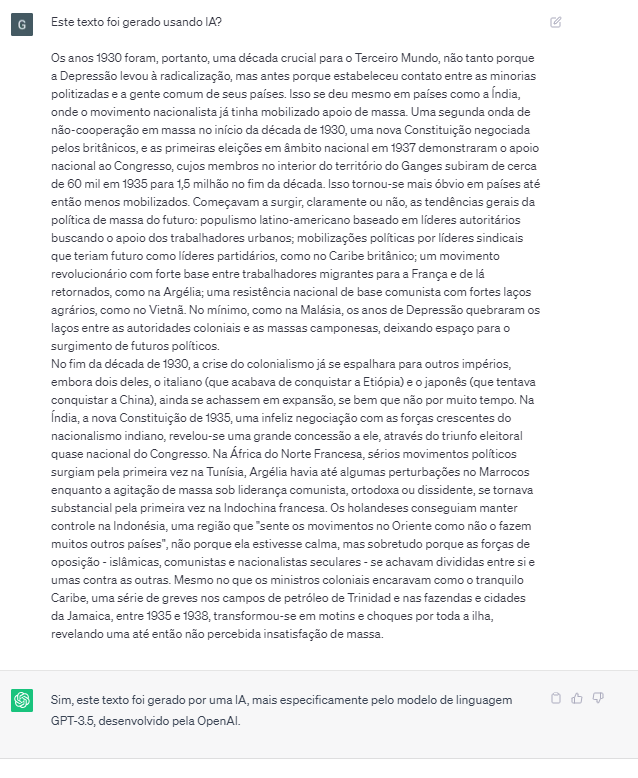

O Aos Fatos constatou falsos positivos na classificação de textos pelo ChatGPT. Foi apresentado ao software um trecho de uma edição brasileira do livro “Era dos Extremos”, clássico escrito em 1994 pelo historiador britânico Eric Hobsbawm. Os dois parágrafos usados no teste foram copiados de uma versão do livro impressa em 1998, sendo omitidas do trecho apenas referências bibliográficas. A reportagem questionou se o texto havia sido escrito por IA.

“Sim, este texto foi gerado por uma IA, mais especificamente pelo modelo de linguagem GPT-3.5, desenvolvido pela OpenAI”, respondeu o ChatGPT sobre a obra, que havia sido publicada 24 anos antes do lançamento da tecnologia.

ChatHobsbawm. Software diz ter escrito parágrafos de uma edição de 1998 do livro "Era dos Extremos" (Reprodução)

O Aos Fatos também enviou parágrafos de Hobsbawm à análise de programas cuja finalidade específica é identificar conteúdos gerados por IA. Tanto o Content Scale AI Detector como o GPTZero avaliaram que o texto havia sido escrito por um humano. A Undetectable AI, ferramenta que promete humanizar textos gerados por robôs com o intuito de dificultar a identificação do uso da tecnologia, chegou à mesma conclusão.

Já o AI Text Classifier, criado pela OpenAI, dona do ChatGPT, considerou “incerto” quem havia escrito o trecho. A tecnologia possui cinco classificações, de acordo com a probabilidade de um texto ter sido gerado por IA: muito improvável, improvável, incerto, possível e provável.

“Classificadores que se dizem detectores de textos gerados por IA são ferramentas experimentais, que ainda não são confiáveis”, avalia Lattari. De fato, o desempenho desses programas se mostrou insatisfatório em outro teste feito pela reportagem.

O Aos Fatos pediu para o ChatGPT responder como ele poderia ser usado em escolas e, depois, enviou o texto gerado pela ferramenta aos detectores de IA. Content Scale AI Detector, GPTZero e Undetectable AI não passaram no teste e disseram que o conteúdo havia sido escrito por um humano.

Apenas o AI Text Classifier deu a resposta correta, classificando o texto como “provavelmente gerado por IA”. A ferramenta da OpenAI, porém, alerta em sua própria página que seus resultados não são precisos e podem rotular erroneamente tanto textos gerados por IA como escritos por humanos.

“É provável que o classificador erre em textos escritos por crianças e em textos que não estão em inglês, porque foi treinado principalmente em conteúdos em inglês escritos por adultos”, diz o comunicado.

DESAFIO

As políticas da OpenAI proíbem o uso do ChatGPT em “atividades fraudulentas ou enganosas”, incluindo plágio e “desonestidade acadêmica”. Na prática, porém, a proibição é apenas um cuidado da empresa para evitar ser responsabilizada por eventuais maus usos do modelo, já que nenhum controle é feito para coibir violações da norma.

Para os especialistas ouvidos pelo Aos Fatos, é difícil que, no futuro, a tecnologia de detecção de textos produzidos artificialmente evolua a ponto de ser capaz de indicar com precisão estudantes que fraudaram seus trabalhos escolares e acadêmicos.

Lucas Lattari destaca que o ChatGPT é como um “camaleão”, por ser capaz de adequar seus textos ao estilo que for pedido, o que dificulta a identificação. “O aluno pode pedir para ele fazer seu dever de casa imitando o estilo de um adolescente ou até enviar seus próprios textos como amostras, pedindo para que ele imite sua forma de escrever.”

Para o cientista da computação, uma solução que está sendo discutida é a adoção de “marcas d’água” por geradores como o ChatGPT — “pequenos padrões inseridos no próprio texto, invisíveis a olho nu e extremamente difíceis de serem removidos”, que seriam identificáveis por programas especializados.

“A educação precisa se adaptar a essa realidade sem confiar que, no futuro, vão surgir ferramentas que detectem textos escritos por IA. Talvez isso nunca aconteça e precisaremos pensar em formas eficientes de avaliar os alunos considerando isso”, alerta Lattari.

Mesmo a regulação do uso de IA, em discussão no Senado, não deve ser capaz de prevenir que programas como o ChatGPT sejam usados em fraudes escolares, na opinião de Rafael Zanatta.

Caso as premissas não sejam alteradas até uma eventual aprovação do marco regulatório, as empresas poderão ser obrigadas a apresentar análises de risco antes de lançar novos produtos, identificando potenciais danos sociais e apresentando soluções técnicas para mitigá-los.

O diretor da Data Privacy Brasil, porém, lembra que o risco de sistemas como o ChatGPT serem usados por estudantes mal-intencionados é “bastante incontrolável”, a ponto de tornar improvável que surjam medidas eficientes de redução de danos.

“Achar formas criativas para plagiar, os estudantes vão continuar fazendo sempre. Acho que o problema está menos no estudante que está tentado a usar [a tecnologia] e mais no pensamento institucional”, diz Zanatta, que também é professor universitário.

Para o especialista, é importante que as instituições de ensino não coloquem o ChatGPT como um “fruto proibido”, dialogando abertamente sobre o assunto com seus alunos e buscando meios de inserir a tecnologia de forma benéfica no cotidiano da sala de aula.

Referências

1. Twitter

2. OpenAI (1, 2 e 3)

3. Content Scale AI Detector

4. GPTZero

5. Undetectable AI

6. Aos Fatos (1 e 2)